Statische und dynamische Codeanalyse in einem kontinuierlichen Testprozess

Zunehmende Variantenvielfalt und steigende Komplexität stellen Entwickler von Embedded Software vor neue Herausforderungen. Kontinuierliche Integration gewinnt daher an Bedeutung. Durch die Kombination statischer und dynamischer Codeanalyse in einem kontinuierlichen Testprozess lässt sich effizient eine nachhaltige Qualitätssteigerung erzielen – die richtigen Analysewerkzeuge vorausgesetzt.

Anbieter zum Thema

Schon der Unternehmensgründer der Bosch Engineering GmbH hatte den Anspruch, ein hohes Maß an Qualität zu erreichen: „Es war mir immer ein unerträglicher Gedanke, es könne jemand bei der Prüfung eines meiner Erzeugnisse nachweisen, dass ich irgendwie Minderwertiges leiste. Deshalb habe ich stets versucht, nur Arbeit hinauszugeben, die jeder sachlichen Prüfung standhielt, also sozusagen vom Besten das Beste war," legte Robert Bosch 1918 in seinen Grundsätzen fest.

Heutzutage kommt noch die Einhaltung vertraglicher Anforderungen, Standards und Gesetze hinzu: „Wird durch den Fehler eines Produkts jemand getötet, sein Körper oder seine Gesundheit verletzt oder eine Sache beschädigt, so ist der Hersteller des Produkts verpflichtet, dem Geschädigten den daraus entstehenden Schaden zu ersetzen,“ heißt es in § 1 Abs. 1 des ProdhaftG, 1990, Haftung.

Umso wichtiger ist es daher, fehlerhaftes Verhalten eingebetteter Systeme auszuschließen. Diese kosten im Fall einer Haftung nicht nur Zeit und Geld, sondern können auch zu einem Imageschaden führen. Interessant ist hierbei, dass aufgrund der steigenden Komplexität und der sich stetig weiterentwickelnden Technologie immer mehr der Mensch als Fehlerquelle in den Vordergrund rückt.

Das Testparadoxon

Immer wieder müssen in Projekten die Barrieren zwischen Entwicklung und Test überwunden werden, bevor konstruktiv an einer Qualitätssteigerung gearbeitet werden kann. Wird beim Testen ein Fehler entdeckt, so zerstört dies meist das Vertrauen der Entwicklung zu Produkt und Prozess. Es gilt aber auch: Ist der Fehler behoben beziehungsweise erst gar nicht vorhanden, so liefert der Test im Idealfall den Nachweis für seine Abwesenheit und schafft Vertrauen.

Gerade im Bereich eingebetteter Systeme ist es daher umso wichtiger, dass Entwickler frühzeitig und direkt eine Rückmeldung bezüglich des aktuellen Entwicklungsstands erhalten. Zudem muss jeder Entwickler in der Lage sein, die entsprechenden statischen und dynamischen Codeanalysen selbst in seiner Entwicklungsumgebung auszuführen, um einem vermeidbaren und somit unnötigen Vertrauensbruch entgegenzuwirken.

Statische Codeanalyse

Das wohl bekannteste und hoffentlich auch meist genutzte Werkzeug für statische Codeanalysen ist das Review. Es deckt so gut wie alles ab. Doch auf Ebene des Quellcodes hat die Erfahrung gezeigt, dass bei alleiniger Nutzung des Reviews der Fokus nach einer gewissen Zeit immer mehr Richtung Trivialitäten und Formalitäten wandert und die vorhandenen funktionalen Fehler übersehen werden. Daher empfiehlt sich die Nutzung von Werkzeugen, die automatisiert und systematisch bei der Quellcodeanalyse unterstützen.

Eines dieser Werkzeuge ist der Compiler, welcher in jeder Software-Build-Kette zu finden ist. Eine Vielzahl lexikaler, syntaktischer und semantischer Analysen bringt der Compiler von Haus aus mit. Jedoch werden häufig in der Prototypenphase die dazugehörigen und wertvollen Warnungen und Fehlermeldungen per Compilerschalter deaktiviert und somit mögliche Fehlerquellen ausgeblendet. Werden diese dann erst zur Serienentwicklung wieder reaktiviert, werden viele Warnungen und Fehler sichtbar und verursachen dadurch einen erheblichen Aufwand bei der Fehlerkorrektur.

Ein weiteres Hilfsmittel stellen die Werkzeuge zur Quellcodeanalyse dar, die unter anderem den Quellcode gegen Standards (bis zu 100% Abdeckung) als auch gegen die projekteigenen Codier-Richtlinien (zwischen 80-90% Abdeckung) prüfen können. Zudem liefern diese Werkzeuge hilfreiche Metriken, mit denen Aussagen zur Komplexität und dem daraus resultierenden Aufwand zum Beispiel für Software-Unit-Tests getroffen werden können. Kombiniert man nun diese drei Methoden geschickt miteinander, so wird der eigentliche Fokus beim Quellcode-Review wieder mehr auf die Funktionalität gelenkt und zudem Zeit eingespart.

Es empfiehlt sich daher, folgende Fragen in der Review-Checkliste zu ergänzen:

- Wurden alle Compilerwarnungen und -fehlermeldungen behoben oder bewertet?

- Wurden alle Warnungen und Fehlermeldungen der Quellcodeanalyse behoben oder bewertet?

- Wurden alle Regeln der Codier-Richtlinien, die manuell geprüft werden müssen, erfüllt oder bewertet?

Dynamische Codeanalyse

Ein Großteil der dynamischen Codeanalyse nimmt die Simulation und Stimulation der zu testenden Funktionalität ein. Kombiniert man diese noch mit einem Werkzeug zum Messen der Codeabdeckung oder ist dieses Werkzeug sogar schon integriert, lassen sich neben der Überprüfung zur Funktionalität auch Aussagen zu fehlenden Testfällen oder nicht erreichbaren bzw. totem Quellcode machen. Viele Sicherheitsstandards fordern genau aus diesen Gründen die Einhaltung der Codeabdeckungswerte entsprechend der für das Produkt zutreffenden Sicherheitsstufe.

Kontinuierliche Integration

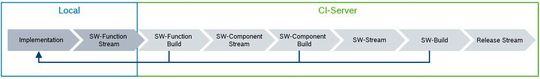

Ziel des kontinuierlichen Integrationsprozesses ist, frühzeitig Integrationsprobleme zu detektieren. Dabei wird die Software stückweise über mehre Teilarchive sogenannte Streams eines Versionsverwaltungssystems zusammengebaut. Hierzu ist allerdings eine vollautomatisierte Software-Build-Kette erforderlich (z.B. Jenkins-Server), welche die entsprechenden Compilerwarnungen und -fehlermeldungen direkt an die Entwicklung weiterleiten kann.

Schnelle Softwareänderungen sind mit diesem System auch kein Problem, solange die Implementierung modular und verständlich gehalten wird. Des Weiteren verhindert dieser Prozess Last-Minute Integrationen und stellt somit sicher, dass für Test, Demonstrationen und Ablieferungen immer ein lauffähiger Software-Build zur Verfügung steht.

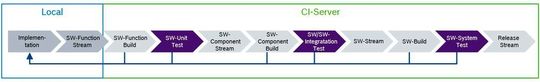

Kontinuierliches Testen

Der kontinuierliche Testprozess ist eine Erweiterung des kontinuierlichen Integrationsprozesses mit zusätzlichen dynamischen Testschritten, um neben den Compilerwarnungen und -fehlermeldungen auch funktionale Fehler zu detektieren. Dies hat den Nebeneffekt, dass die Entwicklung dazu angehalten wird kontinuierlich sauberen und testbareren Quellcode zu schreiben.

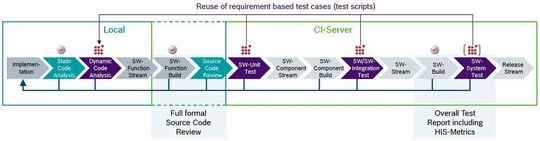

Zudem fördert dieser Prozess die testgetriebene Anforderungs- und Architekturentwicklung, vorausgesetzt die verwendeten Testsysteme können auch hier voll automatisiert betrieben werden. Wird nun noch die zuvor erwähnte Methodenkombination für statische Codeanalyse berücksichtigt (Compilerwarnungen und -fehlermeldungen + Quellcode-Review), so können zusätzlich Regelverletzungen und Schnittstellenfehler mit im kontinuierlichen Testprozess überprüft werden.

Lokale Entwicklungsumgebung

Um dem Testparadoxon entgegenzuwirken ist es zwingend erforderlich, dass Entwicklung und Test in derselben lokalen Entwicklungsumgebung arbeiten können. Hier bietet sich zum Beispiel eine Entwicklungsumgebung wie Eclipse an. Diese erlaubt es unterschiedliche Plug-Ins für statische und dynamische Codeanalyse (z.B. QAC/QAC++ und Cantata) und viele weitere zu integrieren.

Auf der einen Seite kann so die Entwicklung Codeänderungen und deren Auswirkung eigenständig prüfen, bevor diese in den SW-Function Stream eincheckt werden und somit den formellen Testprozess starten. Auf der anderen Seite, bietet es dem Test eine Möglichkeit, entsprechende Lösungsvorschläge zu definieren, in dem die fehlerhaften Stellen temporär modifiziert werden.

Durch Integration dieser lokalen Entwicklungsumgebung in den kontinuierlichen Testprozess können nun auch vorhandene Testskripte auf Entwicklungsseite genutzt werden, was zudem einen schnelle Fehlerbehebung ermöglicht. Mit dem Einsatz geeigneter statischer und dynamischer Codeanalyse Werkzeuge können somit zu jedem Zeitpunkt der Entwicklung im kontinuierlichen Testprozess Aussagen bezüglich der aktuellen Softwarequalität getroffen werden. Zudem lassen sich unterschiedliche Metriken für die Dokumentation und Steuerung des Projektes generieren.

Codeabdeckung

Aus der Praxis wissen wir, dass je größer der betrachtete Systemfokus wird es auch immer schwerer wird eine vollständige Codeabdeckung zu erreichen. Auch startet der Test oft viel zu spät in der Projektlaufzeit. Hinzu kommt noch, dass meistens die Anforderungen auf den detaillierteren Entwicklungsebenen nur spärlich oder sogar überhaupt nicht existieren. Um der Lage dennoch Herr zu werden, vergrößert man die Testteams überproportional.

Ist die Umsetzung des Entwicklungsplans nicht eingehalten, reicht es meistens zeitlich nicht mehr die benötigten Detailanforderungen nachzuziehen. So werden kurzerhand auf Basis des Quellcodes die Testfälle abgeleitet. Problem hierbei ist, dass enorme Kosten verursacht werden ohne effektiven Mehrwert für die Qualität des Produktes (reine Artefaktbefriedigung).

Daher empfiehlt es sich den Fokus auf die nächsthöhere Entwicklungsebene zu legen, in der Anforderungen in einem adäquaten und testbarem Zustand existieren. Größtenteils ist dies auf Architekturebene noch der Fall. Hier können mit vertretbarem Aufwand relative gute Werte bezüglich Codeabdeckung erzielt werden.

Autotestfallgeneratoren auf Software-Unit-Ebene

Auf Basis der zuvor genannten Erfahrungswerte lässt sich nun Folgendes ableiten: Wenn wir wissen, dass im Bereich der Software/Software-Integration mit vertretbarem Testaufwand sehr gute Codeabdeckungswerte erreicht werden können und die Wahrscheinlichkeit höher ist, noch größere gravierende Fehler in der Software zu entdecken (Signalkettenfehler), die der Entwicklung weiterhelfen, warum werden dann nicht auf Software-Unit-Ebene Autotestfallgeneratoren genutzt?

Mit diesem Ansatz kann zum einen die fehlende Codeabdeckung nachgewiesen werden und zum anderen eine zusätzliche funktionale Überprüfung zum Quellcode-Review erfolgen. Ergänzt man hierzu die Review-Checkliste mit folgenden Fragen, ist diese Arbeitsweise legitim:

- Decken die autogenerierten Testfälle die zu testende Funktionalität sinnvoll und vollständig ab?

- Sind die Ergebnisse der autogenerierten Testfälle fehlerfrei?

- Wurde die geforderte Codeabdeckung erreicht?

Können diese Fragen nicht vollständig beantwortet werden, so besteht immer noch die Möglichkeit, manuell fehlende Testfälle zu ergänzen. Unabhängig davon stellt die Funktionalität zur automatischen Generierung von Testfällen zumindest entwicklungsseitig einen großen Nutzen dar, bei der initialen Implementierung eine Art stichprobenartige Funktionsüberprüfung durchzuführen.

:quality(80)/images.vogel.de/vogelonline/bdb/1588600/1588651/original.jpg)

Behaviour Driven Testing und automatische Unit-Test-Generierung

:quality(80)/images.vogel.de/vogelonline/bdb/1518400/1518454/original.jpg)

‚Shift Left‘: Wie man Performance-Tests in der Software-Entwicklung vorverlegt

:quality(80)/images.vogel.de/vogelonline/bdb/1323400/1323442/original.jpg)

Entwicklung vom agilen zum Continuous Testing

Dieser Beitrag stammt aus dem Tagungsband des Embedded Software Engineering Kongress 2016

* Dipl.-Ing. (FH) Matthias Schmidt, Projektleiter bei der Bosch Engineering GmbH, studierte an der Hochschule Karlsruhe Energie- und Automatisierungstechnik. Bei Bosch etablierte er innerhalb videobasierter Assistenzsysteme sein Spezialgebiet SW-Unit Test. Er ist Software-Produkt-Manager für Cantata und arbeitet aktuell als Testmanager in einem Projekt der Bosch General Aviation Technology GmbH.

(ID:44853795)

:quality(80)/p7i.vogel.de/wcms/b8/20/b8203d9f2b6f6e61bff6c3fda15042d3/0128235802v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/90/79901d8c1934b11223a53cb900b1aa85/das-20building-2092-20bei-20der-20microsoft-zentrale-20in-20redmond-20--20quelle-20coolcaesar-20via-20wikimedia-20commons-5184x2915v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/92/3192d2bddbdb052afd8904128dd7aec1/0123884994v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/42/b04293b683f177fa6c781c1e00e1770f/0122968330v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/cc/53/cc53ebfd9f45b28eb918a8098b63846b/0127825678v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ac/ea/acea3ca6c15e0bd261c8bde5d3fe7bfb/0127825678v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/d9/93d9211463a0af86eff0b83c359cd880/0127528428v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/9d/9f9d8357928662c1173bad86e63f0fb0/0126749087v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/3d/753d0fa44b344d363e25c91dc0752635/0129134302v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/9a/ef9a10566eaa807a8fdad9cbff80246f/0126533084v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/2c/f12ce473545edd2bfd6e6608762ab4e0/0127849318v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/f0/4cf066b46a5fcfc430a2454a5e82e801/0129279386v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8c/6f/8c6f6442be2e51474edb322865beea87/0128892896v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/2c/972cdd9c0feba8b1f547ab8b59f20569/0128755598v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/6e/ce6efcc7a619f27ab72ec73ddfa4104a/0128150590v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/77/c3773763653a2c21d1bc56edaeb5ee28/0129073638v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/87/22/8722bf4b4f589ef0fb8edea072ab2233/0128050160v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b9/31/b9313f8284d9693b6fa4da6c8f6fc9cd/0127890201v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/f0/fbf0a08d385a84614563ef9c5f500f90/0126977852v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/b4/6ab425994d3a51adb386ff1f6ac057c4/90781066v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/ae/44ae9d39a71459d2159041970c5af967/0129272409v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/73/1573bb05ef0a53c3b4a9473f9b4397f6/0128933070v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/ff/e3fff7793f39cb358f0b96db2b06680c/0128775174v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/b2/93b2dee2b42d98849c80562a53d8b31e/0128754755v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8f/0c/8f0c1365f6635fbdfdd355b102d3d113/0128531933v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/27/b9/27b9cfbb678630047f85e1adc55f7df7/0114455762.jpeg)

:quality(80)/p7i.vogel.de/wcms/4d/96/4d9621a180cfee96ba85d2da83163461/0105948132.jpeg)

:quality(80)/p7i.vogel.de/wcms/34/05/3405327567eb345e9c0c326a590cd9ae/0105886699.jpeg)

:quality(80)/p7i.vogel.de/wcms/22/89/22896600c7f19a5813fa824ee8207dd4/0122524970v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/cf/e7cf5a22f39eddc3235f047c566b747e/0122159010v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/c4/43c4067994de48347a260c6191e88528/0103046501v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/a1/74a1fcd5d60af69422390e97fbf77dcd/0109296819.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/f6/66f673630a98a/logo-mc-rgb-300x300.png)

:fill(fff,0)/p7i.vogel.de/companies/66/1c/661cd4860acd6/emlix-logo-300x210mm-150dpi-rgb.png)

:fill(fff,0)/p7i.vogel.de/companies/63/8f/638f6ed06f4c8/parasoft-logo-2018.png)

:quality(80)/images.vogel.de/vogelonline/bdb/1274500/1274564/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1274500/1274565/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1589600/1589611/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1589600/1589612/original.jpg)

:quality(80)/p7i.vogel.de/wcms/1d/34/1d344254cdb39af2b2127177e5d92987/0124380591v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/f2/e3f26d3aef77ee57a0c73fda6b78630d/0123195239v2.jpeg)