Höhere Softwarequalität in Automatisierungsanwendungen

Steigende Anforderungen in der Fertigungsautomatisierung erfordern komplexere Steuerungssoftware und kürzere Entwicklungszyklen. Um zukünftig ihre Korrektheit und Zuverlässigkeit sicherstellen zu können, ist eine Anpassung der Qualitätssicherung erforderlich. Die Verifizierung, ein geeignetes Verfahren, wird bisher aufgrund hoher Kosten und Aufwand in der Industrie wenig eingesetzt. Am Lehrstuhl AIS der TU München hat man hierfür nun einen pragmatischen und zugleich zuverlässigen Weg gefunden.

Anbieter zum Thema

Steuerungssoftware für automatisierungstechnische Produktionssysteme (aPS) unterliegt über die Jahre oft kleinen Änderungen. Gleichzeitig gehört die Zuverlässigkeit zu den wichtigsten Anforderungen. Doch wie überprüft man diese, wenn man Änderungen einfügen muss? Ist der Rest der Software unverändert und wurde die Änderung überhaupt korrekt durchgeführt? Schließlich müssen sämtliche Sicherheitsbelange, wie Maschinengefahren oder Unfälle mit Bedienern oder Wartungspersonal, selbst bei einer neuen Version einer Steuerungssoftware berücksichtigt werden.

Von einer weiteren Problematik berichtet Dr. Matthias Bengel, Vice President R+D Software von teamtechnik: „Im Bereich der Medizintechnik müssen Maschinen und Anlagen vor Produktionsbeginn zertifiziert werden, da Fehlfunktionen oder Ausfälle im Produktionssystem für Lebensmittel oder pharmazeutische Produkte Schäden bei den Kunden des Produkts verursachen können.“ Selbst kleine Softwareänderungen nach der Zertifizierung erfordern eine erneute Qualifizierung, um zu gewährleisten, dass die Anlagensoftware weiterhin verlässlich arbeitet. „Diese Re-Qualifizierung bedeutet oftmals einen zusätzlichen Zeitaufwand von mehreren Wochen“, so die Erfahrung von Dr. Bengel.

Formale Verifizierung: In der Industriepraxis wenig genutzt

Die formale Verifizierung erbringt den Nachweis der Richtigkeit einer Implementierung. Sie erlaubt zudem eine einfache aber vollständige erneute Validierung.

Gegen ihren Einsatz spricht, dass hierfür – nach genereller Meinung – Expertenwissen erforderlich ist. Weiter gibt es keine geeigneten Spezifikationssprachen für die Automatisierungsdomäne, die sowohl nachvollziehbar als auch ausreichend aussagekräftig sind. Meist steht noch nicht einmal eine informelle Beschreibung der Anforderungen zur Verfügung. Besonders die Erstellung eines formalen Modells gilt in der Regel als nicht praktikabel. Darum ist die formale Verifizierung bei Ingenieuren in der Praxis nicht sonderlich beliebt.

Aktuell wird in der Industriepraxis die Softwarequalität in der Regel über eine dynamische Validierung durch manuelle schrittweise Prüfung oder automatisch generierte Testfälle überprüft. Allerdings hat diese Vorgehensweise Schwächen. Bei einem Testfall wird nur eine bestimmte Situation geprüft, da sich nicht alle Eventualitäten checken lassen. Aufgrund von Zeitdruck validieren Entwickler selten die Auswirkungen auf das Gesamtsystem. Daraus folgt, dass bestimmte Szenarien ungetestet bleiben. Die Korrektheit der Software kann daher nicht voll nachgewiesen werden, seltene Fehlfunktionen bleiben meist unentdeckt.

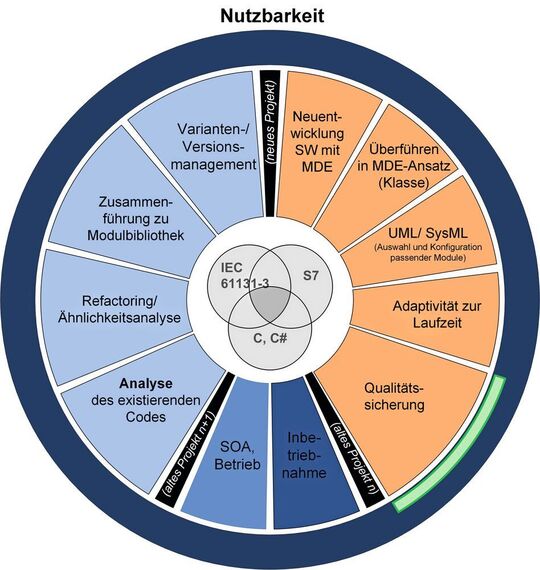

Am Lehrstuhl für Automatisierung und Informationssysteme (AIS) wurde nun eine Methode entwickelt, um die Verifizierung praxistauglicher zu gestalten. Dabei wird ein Evolutionsprozess mit Verifizierung eingeführt. Prinzipiell gilt es hierbei, drei Aufgaben für den Einsatz in der Praxis zu lösen:

- Zunächst müssen die Änderungen zwischen dem ursprünglichen und dem neuen Programm erkannt und verständlich dargestellt werden.

- Auch die Visualisierung muss nutzerfreundlicher werden. Fehler müssen klar zu erkennen sein und eine zeitliche Zuordnung erhalten.

- Außerdem soll ein Tool erstellt werden, das in der Lage ist, die Unterschiede gemäß IEC61131-3 zu verifizieren und welches später in die normale Automatisierungslandschaft integriert werden kann.

Erzeugung generalisierter Test-Tabellen

Einen großen Part bei der Entwicklung der Methode nahm das Erkennen und die Weiterverarbeitung von Software-Fehlern ein, vor allem unter dem Aspekt der Nutzerfreundlichkeit. Im Maschinen- und Anlagenbau behilft man sich beim Testen von Automatisierungsanwendungen meist mit dem Einsatz von Test-Tabellen. Jede dieser Tabellen besteht aus einer Sequenz von Sensoreingängen (Eingabewerte) mit ihren erwarteten Software-Ausgabewerten (berechnet von der zu testenden SPS-Software).

Jede Eingangs- und Ausgangs-Variable hat eine eigene Spalte in der Tabelle und jeder Schritt im Protokoll wird durch eine Zeile in der Tabelle dargestellt. Dadurch lässt sich das System mit dem beschriebenen Testfall vergleichen. Das Problem ist, dass diese Test-Tabellen keinen konkreten Fall repräsentieren und nicht besonders flexibel sind. Erfordern zum Beispiel einige Prozesse flexible Zyklen, etwa wenn sie keine spezifischen Werte enthalten sondern einen Bereich umfassen, ist eine nachträgliche Änderung sehr umständlich, da in den Zellen feste Werte nötig sind.

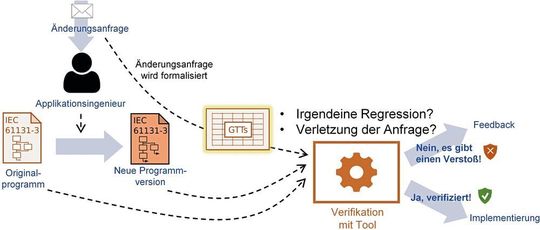

Generalisierte Testtabellen (Generalized Test Tables -GTTs) beruhen auf den oben erwähnten konkreten Testtabellen, werden allerdings etwas offener gestaltet. So verwenden sie allgemeine Werte, nutzen Verweise und die Zeitspanne wird erweitert. Diese GTTs sind zudem besser verständlich und dadurch auch aussagekräftiger. Darüber hinaus können sie Abweichungen zur neuen Software beschreiben, so dass der neu implementierte Code über die Verifizierung validiert werden kann.

Evolutionsprozess mit Verifizierung

Diese generalisierten Testtabellen sind also quasi die Grundlage für den nächsten Schritt: die Verifizierung einer Softwareversion. Generell greift man am AIS dabei auf einen Trick zurück. Da der Aufwand für ein formales Modell sehr hoch ist, geht man beim AIS davon aus, dass die bestehende Software eigentlich richtig ist. Damit wird im Rahmen der Verifizierung zwischen zwei Software-Versionen überprüft, ob das Verhalten der alten, also der existierenden Software, von den Änderungen unbeeinflusst ist, also in der neuen Software identisch ist. Es wird somit nur das Delta, also der Unterschied zwischen dem vorhanden Softwarecode und dem neuen, geprüft und verifiziert. Dadurch lässt sich das Verfahren auch in industriellen Umgebungen anwenden, da die Fehlerbehebung nur in einem kleinen Bereich der Software stattfindet.

Durch die Bereitstellung dieses automatisch generierten Teilmodells und dank der verständlicheren Spezifikationssprache (GTT) können Entwickler die Unterschiede zwischen den Versionen besser in einer formalen Sprache beschreiben. Dies erleichtert die Überprüfung. So lässt sich die Softwarequalität selbst bei vielen Änderungen über einen langen Zeitraum hochhalten.

Fazit: Weniger Aufwand und Kosten bei Re-Qualifizierung

Die Verifizierung ist noch keine etablierte Validierungsmethode für automatisierte Produktionssysteme. Aber: „Die Anwendung von Regressionsverifikation zur schnellen und gezielte Analyse geänderter Softwareteile und deren Auswirkungen würde den langwierigen Re-Qualifizierungsschritt in unserer Branche verkürzen und somit kostengünstiger machen“, meint Dr. Bengel. „Es muss sichergestellt sein, dass nur beabsichtigte Verhaltensänderungen der Software durch die getätigte Änderung hervorgerufen werden und keine unbeabsichtigte Funktionalität oder Verhaltensänderung eingebracht wurde.“ Verfahren wie das Testen in Kombination mit Regressionsverifikation durch ein vollständiges Prüfen von Änderungen und ihren Auswirkungen trügen dazu bei, Anlagensoftware zuverlässiger und sicherer zu machen, und der Aufwand und die Kosten der Re-Qualifizierung ließe sich senken.

Zudem rückt diese Technologie im Industrie-4.0-Umfeld in den Vordergrund. In Zukunft gibt es mehr flexible Systeme, die aber gleichzeitig immer enger zusammenarbeiten. Die dafür nötige Software erfordert nicht nur die strikte Einhaltung von Regeln, sondern muss auch entsprechend robust sein und qualitativ hochwertig bleiben.

Der Ansatz der TU München verwendet eine Modellprüfung, welche systematisch die jeweiligen gewünschten Verhaltenseigenschaften aller Zustände des Systemmodells testet. Durch die Ausführung der Verifikation stellen diese Methoden sicher, dass die Software-Korrektheit in Bezug auf die Spezifikation stimmt, ohne das System tatsächlich auszuführen. Vor allem die Verwendung von generalisierten Testtabellen zeigt, dass dies ein pragmatischer, auch im industriellen Umfeld gangbarer Weg ist.

Ebenfalls aus der Reihe „Optimierung von Automatisierungsanwendungen“ der TU München:

:quality(80)/images.vogel.de/vogelonline/bdb/1646600/1646650/original.jpg)

Softwareoptimierung für Automatisierungsanwendungen

:quality(80)/images.vogel.de/vogelonline/bdb/1660400/1660426/original.jpg)

Optimierung für Automatisierungsanwendungen: Kosten richtig einschätzen

:quality(80)/images.vogel.de/vogelonline/bdb/1661100/1661187/original.jpg)

Optimierung von Automations-Software: Effizientes Variantenmanagement

* Prof. Dr.-Ing. Birgit Vogel-Heuser leitet als Ordinaria den Lehrstuhl für Automatisierung und Informationssysteme der Technischen Universität München.

* Suhyun Cha, M.Sc. ist wissenschaftliche Mitarbeiterin am Lehrstuhl für Automatisierung und Informationssysteme der Technischen Universität München.

(ID:46305574)

:quality(80)/p7i.vogel.de/wcms/b8/20/b8203d9f2b6f6e61bff6c3fda15042d3/0128235802v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/90/79901d8c1934b11223a53cb900b1aa85/das-20building-2092-20bei-20der-20microsoft-zentrale-20in-20redmond-20--20quelle-20coolcaesar-20via-20wikimedia-20commons-5184x2915v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/92/3192d2bddbdb052afd8904128dd7aec1/0123884994v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/42/b04293b683f177fa6c781c1e00e1770f/0122968330v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/cc/53/cc53ebfd9f45b28eb918a8098b63846b/0127825678v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ac/ea/acea3ca6c15e0bd261c8bde5d3fe7bfb/0127825678v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/d9/93d9211463a0af86eff0b83c359cd880/0127528428v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/9d/9f9d8357928662c1173bad86e63f0fb0/0126749087v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/3d/753d0fa44b344d363e25c91dc0752635/0129134302v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/9a/ef9a10566eaa807a8fdad9cbff80246f/0126533084v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/2c/f12ce473545edd2bfd6e6608762ab4e0/0127849318v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/f0/4cf066b46a5fcfc430a2454a5e82e801/0129279386v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8c/6f/8c6f6442be2e51474edb322865beea87/0128892896v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/2c/972cdd9c0feba8b1f547ab8b59f20569/0128755598v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/6e/ce6efcc7a619f27ab72ec73ddfa4104a/0128150590v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/77/c3773763653a2c21d1bc56edaeb5ee28/0129073638v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/87/22/8722bf4b4f589ef0fb8edea072ab2233/0128050160v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b9/31/b9313f8284d9693b6fa4da6c8f6fc9cd/0127890201v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/f0/fbf0a08d385a84614563ef9c5f500f90/0126977852v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/b4/6ab425994d3a51adb386ff1f6ac057c4/90781066v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/ae/44ae9d39a71459d2159041970c5af967/0129272409v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/73/1573bb05ef0a53c3b4a9473f9b4397f6/0128933070v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/ff/e3fff7793f39cb358f0b96db2b06680c/0128775174v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/b2/93b2dee2b42d98849c80562a53d8b31e/0128754755v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8f/0c/8f0c1365f6635fbdfdd355b102d3d113/0128531933v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/27/b9/27b9cfbb678630047f85e1adc55f7df7/0114455762.jpeg)

:quality(80)/p7i.vogel.de/wcms/4d/96/4d9621a180cfee96ba85d2da83163461/0105948132.jpeg)

:quality(80)/p7i.vogel.de/wcms/34/05/3405327567eb345e9c0c326a590cd9ae/0105886699.jpeg)

:quality(80)/p7i.vogel.de/wcms/22/89/22896600c7f19a5813fa824ee8207dd4/0122524970v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/cf/e7cf5a22f39eddc3235f047c566b747e/0122159010v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/c4/43c4067994de48347a260c6191e88528/0103046501v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/a1/74a1fcd5d60af69422390e97fbf77dcd/0109296819.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/f6/66f673630a98a/logo-mc-rgb-300x300.png)

:fill(fff,0)/p7i.vogel.de/companies/66/1c/661cd4860acd6/emlix-logo-300x210mm-150dpi-rgb.png)

:fill(fff,0)/p7i.vogel.de/companies/63/8f/638f6ed06f4c8/parasoft-logo-2018.png)

:quality(80)/images.vogel.de/vogelonline/bdb/1661100/1661177/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1661100/1661184/original.jpg)

:quality(80)/p7i.vogel.de/wcms/44/9f/449f53a653a67605236ee82e4e7f32a5/0128840399v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/a4/99a4d56dbc561f9f131603484aa9cd7b/0125172130v2.jpeg)