Das Vorurteil der Maschine – die wahre Gefahr ist nicht nachvollziehbare KI

Gängige Bedrohungsszenarien zur Künstlichen Intelligenz warnen vor ihren vermeintlich überlegenen Fähigkeiten. Die wahre Gefahr liege aber eher in ihrer Überschätzung und im blinden Vertrauen in die ihre nur scheinbare Objektivität, meinen Chemnitzer Professoren. Sie plädieren: KI muss nachvollziehbar sein!

Anbieter zum Thema

Künstliche Intelligenz ist kein neues Thema. Die theoretischen und philosophischen Betrachtungen zu KI reichen bis in die Anfänge der Informatik in der Mitte des 20. Jahrhunderts zurück. Trotz erster Erfolge in den frühen 1980ern, etwa im Bereich der Handschriftenerkennung, findet KI erst heute Beachtung in der breiten Öffentlichkeit. Dabei ist der aktuelle Fortschritt der KI weniger auf grundlegend neue Konzepte zurückzuführen als vielmehr auf eine gebündelte Verfügbarkeit riesiger Datenmengen – den Big Data.

Das Versprechen: Erkennen von verborgenen Mustern und Informationen

KI kann in riesigen Datenmengen Muster erkennen: Beispielsweise lernt sie anhand unzähliger Fotos von Haustieren, die mit dem Etikett (Label) „Hund“ oder „Katze“ verknüpft sind, diese Tierarten auseinanderzuhalten. Dafür muss man der KI nicht beibringen, was einen Hund von einer Katze unterscheidet - es genügen die Fotos und deren Labels. Die KI erlernt daraus selbständig die relevanten Unterscheidungsmerkmale. Interessant wird diese selbstlernende KI dann, wenn sie Muster erkennt, die dem Menschen selbst bisher verborgen blieben. Welche Merkmale unterscheiden beispielsweise kreditwürdige von weniger kreditwürdigen Personen?

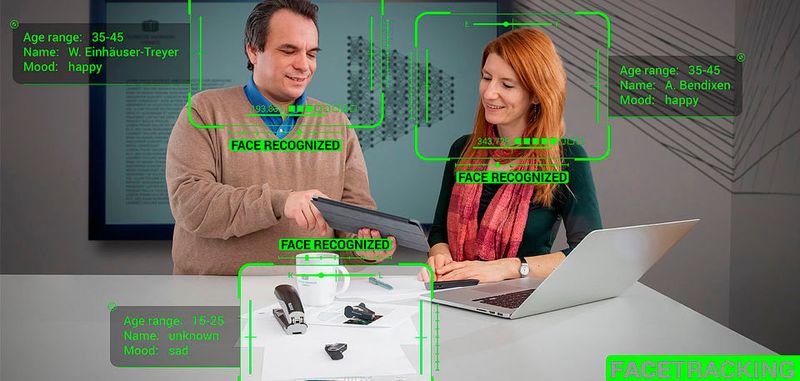

Entsprechend groß sind die Hoffnungen auf mögliche Anwendungen. Gesellschaftlich und individuell hoch bedeutsame Entscheidungen sollen der KI überlassen werden: von der Kreditvergabe über die medizinische Behandlung bis hin zur Vorhersage von potentiell gefährlichen Handlungen im öffentlichen Raum anhand von Videomaterial. Durch den scheinbar objektiven Algorithmus – so die Hoffnung – sollen „bessere“, „schnellere“ und vor allem „gerechtere“ Entscheidungen getroffen werden als bei der Beurteilung durch vermeintlich vorurteilsbehaftete Menschen.

Die unvermeidliche Schwäche: eine verzerrte Datenbasis

Das klingt zunächst vielversprechend – aber sind die Entscheidungen der KI wirklich objektiv und neutral? Das können sie nur sein, wenn die verfügbare Datenbasis keine Verzerrungen beinhaltete. Wenn eine bestimmte Katzenart in der Datenbasis viel zu selten vertreten war, kann es passieren, dass der Algorithmus solche Katzen nicht korrekt zu erkennen lernt.

Dieses Beispiel ist nicht zufällig gewählt: Ein besonders schwerer KI-Fehler genau dieser Art führte vor einigen Jahren völlig zu Recht zu einem öffentlichen Aufschrei – die automatische Bilderkennungssoftware einer großen Softwarefirma hatte ein Foto einer Gruppe von Afroamerikanern fälschlicherweise als „Gorillas“ klassifiziert. Wie kann eine derart gravierende Fehlklassifikation passieren? In der zugrundeliegenden Datenbank war die Kategorie „Mensch“ vermutlich massiv in Richtung hellhäutiger Personen verzerrt – mit anderen Worten: Es waren viel mehr Bilder hellhäutiger als dunkelhäutiger Menschen vertreten.

Dieses tragische Beispiel zeigt, wie aus der verzerrten Zusammensetzung einer Datenbank ein dramatisches Fehlurteil entstehen kann, das man einem Menschen zu Recht als schlimmste Diskriminierung vorwerfen würde.

Abwälzen von Verantwortung und Mangel an Nachvollziehbarkeit

Verzerrungen in den Datenbanken, mit denen selbstlernende Algorithmen trainiert werden, führen also im wahrsten Wortsinn zu Vorurteilen bei der Bewertung individueller Fälle. Die Problematik solcher vorurteilsbehafteten Entscheidungen wird weiter verstärkt, wenn sich die Ausführenden dieser Verzerrungen nicht bewusst sind oder die Verantwortung auf die scheinbar objektiv urteilende KI abwälzen: „Der Computer hat auf Basis Ihrer Daten entschieden, dass Sie keinen Kredit erhalten, da kann ich als Bankangestellter nichts machen.“

Man könnte gegen diese Kritik zunächst einwenden, dass auch Menschen ihren eigenen Vorurteilen unterliegen. Dieser Einwand ist zweifelsfrei berechtigt, doch kann der Mensch gezwungen werden, sich mit diesen Vorurteilen auseinanderzusetzen und Verantwortung für seine Entscheidungen zu übernehmen. Solch eine Zuschreibung von Verantwortung bleibt selbst dann möglich, wenn sich der Entscheider der Quelle seiner Vorurteile und dem Ablauf seiner Entscheidungsprozesse nicht vollumfänglich bewusst ist. Bei der selbstlernenden KI liegen die Verzerrungen – also die Vorurteile – schon in der Datenbank begründet, mit der sie trainiert wird.

Hinzu kommt, dass bei hinreichend komplexen Systemen in der Regel nicht mehr nachvollziehbar ist, auf welcher Grundlage eine Entscheidung getroffen wurde – auf welchen Merkmalen die Entscheidung also basierte und wie diese miteinander verknüpft wurden. Nachvollziehbarkeit von und Verantwortlichkeit für Entscheidungsprozesse sind aber die zentralen Voraussetzungen für die Akzeptanz von Entscheidungen und Grundlage jeder gesellschaftlichen und rechtlichen Ordnung, der solche Entscheidungen zu Grunde liegen.

Keine Korrekturmöglichkeit maschineller Vorurteile

Man könnte weiter einwenden, dass mit hinreichenden Datenmengen das Problem der Verzerrung der Datenbanken nach und nach vernachlässigbar werde. Gerade am Beispiel der Kreditwürdigkeit stellt man jedoch schnell fest, dass sich die Verzerrungen der Datenbank nicht mehr rückgängig machen lassen, sobald man beginnt, den Entscheidungen der KI zu folgen. Wenn Kredite also an bestimmte Personengruppen nicht mehr vergeben werden, so wird man auch keine Daten mehr zu der Frage sammeln, ob die Personen am Ende doch kreditwürdig gewesen wären. Die Datenbasis bleibt verzerrt; die Entscheidungen bleiben vorurteilsbehaftet. Dasselbe Problem führt übrigens auch beim Menschen in vielen Fällen zur hartnäckigen Festsetzung von Vorurteilen, die sich durch eine größere Datenbasis leicht abbauen ließen.

(ID:45720971)

:quality(80)/p7i.vogel.de/wcms/b8/20/b8203d9f2b6f6e61bff6c3fda15042d3/0128235802v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/90/79901d8c1934b11223a53cb900b1aa85/das-20building-2092-20bei-20der-20microsoft-zentrale-20in-20redmond-20--20quelle-20coolcaesar-20via-20wikimedia-20commons-5184x2915v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/92/3192d2bddbdb052afd8904128dd7aec1/0123884994v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/42/b04293b683f177fa6c781c1e00e1770f/0122968330v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/cc/53/cc53ebfd9f45b28eb918a8098b63846b/0127825678v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ac/ea/acea3ca6c15e0bd261c8bde5d3fe7bfb/0127825678v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/d9/93d9211463a0af86eff0b83c359cd880/0127528428v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/9d/9f9d8357928662c1173bad86e63f0fb0/0126749087v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/3d/753d0fa44b344d363e25c91dc0752635/0129134302v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/9a/ef9a10566eaa807a8fdad9cbff80246f/0126533084v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/2c/f12ce473545edd2bfd6e6608762ab4e0/0127849318v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/f0/4cf066b46a5fcfc430a2454a5e82e801/0129279386v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8c/6f/8c6f6442be2e51474edb322865beea87/0128892896v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/2c/972cdd9c0feba8b1f547ab8b59f20569/0128755598v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/6e/ce6efcc7a619f27ab72ec73ddfa4104a/0128150590v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/77/c3773763653a2c21d1bc56edaeb5ee28/0129073638v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/87/22/8722bf4b4f589ef0fb8edea072ab2233/0128050160v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b9/31/b9313f8284d9693b6fa4da6c8f6fc9cd/0127890201v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/f0/fbf0a08d385a84614563ef9c5f500f90/0126977852v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/b4/6ab425994d3a51adb386ff1f6ac057c4/90781066v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/ae/44ae9d39a71459d2159041970c5af967/0129272409v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/73/1573bb05ef0a53c3b4a9473f9b4397f6/0128933070v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/ff/e3fff7793f39cb358f0b96db2b06680c/0128775174v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/b2/93b2dee2b42d98849c80562a53d8b31e/0128754755v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8f/0c/8f0c1365f6635fbdfdd355b102d3d113/0128531933v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/27/b9/27b9cfbb678630047f85e1adc55f7df7/0114455762.jpeg)

:quality(80)/p7i.vogel.de/wcms/4d/96/4d9621a180cfee96ba85d2da83163461/0105948132.jpeg)

:quality(80)/p7i.vogel.de/wcms/34/05/3405327567eb345e9c0c326a590cd9ae/0105886699.jpeg)

:quality(80)/p7i.vogel.de/wcms/22/89/22896600c7f19a5813fa824ee8207dd4/0122524970v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/cf/e7cf5a22f39eddc3235f047c566b747e/0122159010v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/c4/43c4067994de48347a260c6191e88528/0103046501v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/a1/74a1fcd5d60af69422390e97fbf77dcd/0109296819.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/f6/66f673630a98a/logo-mc-rgb-300x300.png)

:fill(fff,0)/p7i.vogel.de/companies/5f/bf/5fbfdf326d5dd/rti-logo-color-200px.jpg)

:quality(80)/p7i.vogel.de/wcms/32/af/32afc3120868044f47053846a044452f/0126510646v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/5a/97/5a973bc05f9f030b279638b454c771e4/0122980927v2.jpeg)