Anbieter zum Thema

Neuheiten: Intel Nervana

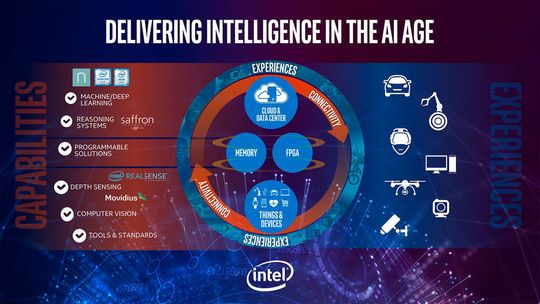

Intel hat am 17. November 2016 seine KI-Plattform vorgestellt: Nervana. Was vorher ein bekannter NN-Cluster war, soll nun performante AI-Lösungen ermöglichen. Der Nervana Graph Compiler stellt NN-Topologien dar und optimiert sie, das Intel DL SDK erlaubt die Erstellung von App auf dem gewählten Framework. Die Software kommt von Nervanas DL-Framework Neon .

Die Hardware stellen die Xeon-CPUs, die Xeon-Phi-Koprozessoren und FPGAs (field-programmable gate arrays). Dafür werden zwei Chips entwickelt. „Lake Crest“ ist ein Chip, der hohe Rechenleistung für DL-NNs mit großer Bandbreite vereint, und „Knight's Mill“ ist ein Xeon-Phi-Prozessor, der die bisherige DL-Leistung vervierfachen soll.

Auch die nächste Xeon-Generation, die den Codenamen Skylake trägt, soll Mitte 2017 mit der Technologie AVX-512 eine erhebliche Beschleunigung der Inferenz-Prozesse im Machine Learning erlauben. Was Intel demonstrieren will: Deep Learning ist keine Domäne der GPUs, sondern CPUs können hier ebenfalls punkten, besonders wenn sie über Intels Math Kernel Library MKL und die Data Analytics Acceleration Library DAAL verfügen.

Intel Saffron ist eine Cognitive-Computing-Lösung, die auf In-memory-Reasoning-Prozesse setzt, die auf heterogene Daten angewandt werden. Was ähnlich etwa wie IBM Watson klingt, soll aber auch Platz in kleinen Geräten wie Smartphones und IoT-Endgeräten finden. Entsprechende Programmierschnittstellen sollen unter andrem in Intel-Geräten wie der 3D-Kamera RealSense ihren „Sehnerv“, unterstützen.

Intel beschreibt Movidus wie folgt: „Movidius bietet energiesparende High-Performance-System-on-Chip- Plattformen an, mit deren Hilfe Bildverarbeitungsanwendungen beschleunigt werden können. Zudem werden von Movidius Algorithmen bereitgestellt, die speziell auf die Bereiche Deep Learning, Depth Processing, Navigation und Kartierung sowie natürliche Interaktion ausgelegt sind und haben breites Know-how bei Embedded Computer Visions und Machine Intelligence.“

Neuheiten: IBM PowerAI

IBM charakterisiert ihre ebenfalls Mitte November vorgestellte Plattform „PowerAI“ als Lösung aus Hard- und Software, „die die doppelte Rechenleistung im Vergleich zu vergleichbaren Servern mit vier GPUs bietet, auf denen AlexNet mit Caffe ausgeführt wird.“ Die gleiche Konfiguration soll auch Konfigurationen aus acht GPU-basierten x86-Servern rechts überholen können, solange die IBM-eigene POWER8+-CPU verwendet wird.

PowerAI unterstützt fünf AI-Frameworks, darunter Caffe und Theano. Ebenso wichtig sind die Programmierbibliotheken im Toolkit. Es sind GPU-DL-Libraries für cuDNN, cuBAS und NCCL als Bestandteile des Nvidia-SDKs. Sie sollen es Apps ermöglichen, die Beschleunigung mehrerer GPUs auf den aktuellen, optimierten IBM-Servern der Reihe S822LC zu nutzen (L steht für „Linux“, C für „Cloud“). Die Linux-Distributionen der Wahl sind hierbei RHEL, SLES und Ubuntu 14.4. Für Kunden mit S822LC ist PowerAI kostenlos. Das Toolkit lasse sich auf einem Einzel-Server ausführen wie auch auf großen Supercomputing-Clustern.

Ausblick

Intel will die Leistung von DL-Frameworks binnen dreier Jahre ab 2017 um den Faktor 100 steigern. Intels CEO Brian Krzanich verspricht eine AI-Revolution, die in den Startlöchern steht, um die Gesellschaft zu verbessern, sei es in der Krebserkennung, in der Genomforschung, im Bergbau, in der Ausbildung – oder im eingangs erwähnten autonomen Fahren.

Was für IBM Cognitive Computing auf Watson-Basis, das ist bei Intel ein umfassendes Chip- und Software-basiertes Ökosystem von Technologien namens Nervana. Intel reklamiert 80 Prozent Marktanteil im High Performance Computing für sich und unterstützt kleine Endgeräte sowie IoT. IBM setzt vor allem seine POWER-CPU für Server und die Open Power Plattform. Der Interessent hat also immerhin klare Wahlmöglichkeiten.

Dieser Beitrag erschien ursprünglich auf unserer Partnerplattform BigData-Insider.

(ID:44443137)

:quality(80)/p7i.vogel.de/wcms/b8/20/b8203d9f2b6f6e61bff6c3fda15042d3/0128235802v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/90/79901d8c1934b11223a53cb900b1aa85/das-20building-2092-20bei-20der-20microsoft-zentrale-20in-20redmond-20--20quelle-20coolcaesar-20via-20wikimedia-20commons-5184x2915v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/92/3192d2bddbdb052afd8904128dd7aec1/0123884994v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/42/b04293b683f177fa6c781c1e00e1770f/0122968330v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/cc/53/cc53ebfd9f45b28eb918a8098b63846b/0127825678v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ac/ea/acea3ca6c15e0bd261c8bde5d3fe7bfb/0127825678v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/d9/93d9211463a0af86eff0b83c359cd880/0127528428v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/9d/9f9d8357928662c1173bad86e63f0fb0/0126749087v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/3d/753d0fa44b344d363e25c91dc0752635/0129134302v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/9a/ef9a10566eaa807a8fdad9cbff80246f/0126533084v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/2c/f12ce473545edd2bfd6e6608762ab4e0/0127849318v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/f0/4cf066b46a5fcfc430a2454a5e82e801/0129279386v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8c/6f/8c6f6442be2e51474edb322865beea87/0128892896v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/2c/972cdd9c0feba8b1f547ab8b59f20569/0128755598v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/6e/ce6efcc7a619f27ab72ec73ddfa4104a/0128150590v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/77/c3773763653a2c21d1bc56edaeb5ee28/0129073638v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/87/22/8722bf4b4f589ef0fb8edea072ab2233/0128050160v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b9/31/b9313f8284d9693b6fa4da6c8f6fc9cd/0127890201v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/f0/fbf0a08d385a84614563ef9c5f500f90/0126977852v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/b4/6ab425994d3a51adb386ff1f6ac057c4/90781066v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/ae/44ae9d39a71459d2159041970c5af967/0129272409v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/73/1573bb05ef0a53c3b4a9473f9b4397f6/0128933070v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/ff/e3fff7793f39cb358f0b96db2b06680c/0128775174v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/b2/93b2dee2b42d98849c80562a53d8b31e/0128754755v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8f/0c/8f0c1365f6635fbdfdd355b102d3d113/0128531933v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/27/b9/27b9cfbb678630047f85e1adc55f7df7/0114455762.jpeg)

:quality(80)/p7i.vogel.de/wcms/4d/96/4d9621a180cfee96ba85d2da83163461/0105948132.jpeg)

:quality(80)/p7i.vogel.de/wcms/34/05/3405327567eb345e9c0c326a590cd9ae/0105886699.jpeg)

:quality(80)/p7i.vogel.de/wcms/22/89/22896600c7f19a5813fa824ee8207dd4/0122524970v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/cf/e7cf5a22f39eddc3235f047c566b747e/0122159010v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/c4/43c4067994de48347a260c6191e88528/0103046501v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/a1/74a1fcd5d60af69422390e97fbf77dcd/0109296819.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/f6/66f673630a98a/logo-mc-rgb-300x300.png)

:fill(fff,0)/p7i.vogel.de/companies/5f/bf/5fbfdf326d5dd/rti-logo-color-200px.jpg)

:quality(80)/p7i.vogel.de/wcms/56/a3/56a3c9077b8dfe8fbb34d3ecc1284cc1/0127608937v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/c3/31c3c246d0b289ecb050ee67dd8ea456/0125490401v2.jpeg)