Anbieter zum Thema

Dynamische Speicher-Allokation in Echtzeitbetriebssystemen

Auch im Bereich der dynamischen RAM-Allokation spielt das deterministische Zeitverhalten eine wichtige Rolle. Bei vielen normalen Betriebssystemen wird Speicher aus einem Heap zugewiesen. Die Services „malloc“ und „free“, bekannt aus der C-Programmierung, arbeiten mit einem Heap. Über den Aufruf von „malloc“ kann eine Task Speicherbereiche aus dem Betriebssystem-Heap temporär nutzen und die erforderliche Speichergröße definieren.

Wenn diese (oder eine andere) Task den Inhalt des entsprechenden Speichers abgearbeitet hat, kann sie den Speicher über den Aufruf von „free“ an das Betriebssystem zurückgeben. Das Betriebssystem gibt den Speicher an den Heap zurück, wo er z.B. als Teil eines großen Puffers wiederverwendet oder später in mehrere kleinere Puffer aufgeteilt werden kann.

Die bei Heaps auftretende „externe Speicherfragmentierung“ kann die Leistung der Heap-Services beeinträchtigen: Ein Puffer, der dem Heap zurückgegeben wurde, wird möglicherweise in kleinere Puffer aufgebrochen, sobald über einen „malloc“-Aufruf kleinere Puffergrößen anfordert werden. Ein Heap, der bereits mehrere malloc- und free-Zyklen durchlaufen hat, weist häufig kleinere Speicherabschnitte zwischen den Pufferspeicherbereichen auf, die von den Tasks verwendet werden.

Diese Abschnitte sind so klein, dass sie für die Tasks nicht nutzbar sind. Jedoch stecken sie zwischen den Puffern fest, die von den Tasks verwendet werden, und lassen sich deshalb nicht in zusammenhängende Puffer mit nutzbarer Größe zusammenfügen. Mit der Zeit hat ein Heap immer mehr dieser kleinen, nicht nutzbaren Speicherabschnitte. Dies kann dazu führen, dass Anfragen einer Task (malloc) nach Pufferspeicher mit einer bestimmten Größe vom Betriebssystem nicht bedient werden, obwohl im Heap genügend Speicher zur Verfügung steht. Dieser Speicher ist jedoch in sehr kleine Abschnitte zerteilt, die sich an verschiedensten Stellen im Heap befinden. Im Kontext von Betriebssystemen bezeichnet man diese Abschnitte als „Fragmente“ und das damit verbundene Problem als „externe Speicherfragmentierung“.

Dieses Problem der Fragmentierung lässt sich durch eine sogenannte „Garbage Collection“ Software zur automatischen Speicherbereinigung beheben (Defragmentierung). Leider sind Garbage Collection Algorithmen oft alles andere als deterministisch und verursachen zufällig auftretende Delays mit zufälliger Dauer in den Heap-Services. Dazu kommt es häufig in den Speicherallokations-Services normaler Betriebssysteme.

Embedded-Software-Entwickler, die ein normales Betriebssystem verwenden wollen, stecken also in der Klemme. Dürfen in dem Embedded-System gelegentlich zufällige Delays von zufällig langer Dauer auftreten, wenn die Garbage Collection ausgeführt wird? Oder erlaubt man dem Embedded-System, seinen Speicher zu fragmentieren, bis „malloc“-Anforderungen der Applikationssoftware an den Heap zurückgewiesen werden, obwohl noch genügend freier Speicher zur Verfügung steht? Für Embedded-Systeme, die ihre Services über lange Zeitspannen zuverlässig erbringen müssen, ist keiner der beiden Ansätze akzeptabel.

Echtzeitbetriebssysteme dagegen umgehen dieses Dilemma, indem sie sowohl die Speicherfragmentierung und Garbage Collection als auch die damit verbundenen Folgen vermeiden. Sie verwenden eine nicht-fragmentierende Speicherallokation anstelle von Heaps und stellen der Applikationssoftware nur bestimmte Speichergrößen zur Verfügung. Dieser Ansatz ist zwar nicht so flexibel wie der Einsatz von Speicher-Heaps. Die externe Speicherfragmentierung wird so jedoch vermieden, und es ist keine Defragmentierung erforderlich.

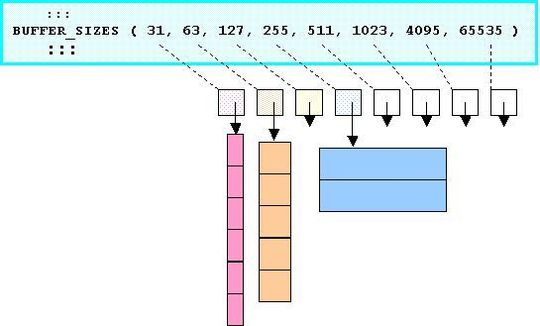

Der „Pools“-Mechanismus zur Speicherallokation beispielsweise ermöglicht es, Speicherbereiche mit 4 oder 8 verschiedenen Größen je Pool zuzuweisen. Pools vermeiden die externe Speicherfragmentierung und gestatten nicht, dass ein an den Pool zurückgegebener Puffer später in kleinere Teile gesplittet wird. Der Puffer kommt stattdessen bei Rückgabe auf eine Liste freier Puffer derselben Größe (free buffer list).

Diese Puffer stehen dann in ihrer ursprünglichen Größe zur Wiederverwendung zur Verfügung, siehe Bild 7. Die Speicherallokation und -deallokation erfolgt mit deterministischem und oft konstantem Timing.

(ID:44941011)

:quality(80)/p7i.vogel.de/wcms/b8/20/b8203d9f2b6f6e61bff6c3fda15042d3/0128235802v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/90/79901d8c1934b11223a53cb900b1aa85/das-20building-2092-20bei-20der-20microsoft-zentrale-20in-20redmond-20--20quelle-20coolcaesar-20via-20wikimedia-20commons-5184x2915v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/92/3192d2bddbdb052afd8904128dd7aec1/0123884994v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/42/b04293b683f177fa6c781c1e00e1770f/0122968330v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/cc/53/cc53ebfd9f45b28eb918a8098b63846b/0127825678v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ac/ea/acea3ca6c15e0bd261c8bde5d3fe7bfb/0127825678v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/d9/93d9211463a0af86eff0b83c359cd880/0127528428v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/9d/9f9d8357928662c1173bad86e63f0fb0/0126749087v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/3d/753d0fa44b344d363e25c91dc0752635/0129134302v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/9a/ef9a10566eaa807a8fdad9cbff80246f/0126533084v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/2c/f12ce473545edd2bfd6e6608762ab4e0/0127849318v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8c/6f/8c6f6442be2e51474edb322865beea87/0128892896v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/2c/972cdd9c0feba8b1f547ab8b59f20569/0128755598v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/6e/ce6efcc7a619f27ab72ec73ddfa4104a/0128150590v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b9/31/b9313f8284d9693b6fa4da6c8f6fc9cd/0127890201v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/77/c3773763653a2c21d1bc56edaeb5ee28/0129073638v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/87/22/8722bf4b4f589ef0fb8edea072ab2233/0128050160v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/f0/fbf0a08d385a84614563ef9c5f500f90/0126977852v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/b4/6ab425994d3a51adb386ff1f6ac057c4/90781066v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/73/1573bb05ef0a53c3b4a9473f9b4397f6/0128933070v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/ff/e3fff7793f39cb358f0b96db2b06680c/0128775174v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/b2/93b2dee2b42d98849c80562a53d8b31e/0128754755v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/3c/f73cfd23b4bbbdea6d4c6e4dc9da6f44/0128505598v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8f/0c/8f0c1365f6635fbdfdd355b102d3d113/0128531933v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/27/b9/27b9cfbb678630047f85e1adc55f7df7/0114455762.jpeg)

:quality(80)/p7i.vogel.de/wcms/4d/96/4d9621a180cfee96ba85d2da83163461/0105948132.jpeg)

:quality(80)/p7i.vogel.de/wcms/34/05/3405327567eb345e9c0c326a590cd9ae/0105886699.jpeg)

:quality(80)/p7i.vogel.de/wcms/22/89/22896600c7f19a5813fa824ee8207dd4/0122524970v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/cf/e7cf5a22f39eddc3235f047c566b747e/0122159010v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/c4/43c4067994de48347a260c6191e88528/0103046501v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/a1/74a1fcd5d60af69422390e97fbf77dcd/0109296819.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/f6/66f673630a98a/logo-mc-rgb-300x300.png)

:quality(80)/p7i.vogel.de/wcms/cc/53/cc53ebfd9f45b28eb918a8098b63846b/0127825678v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/32/9c321afd6b36024f1ce389d8bc9436c4/0124124497v1.jpeg)